Photo: gguy/Shutterstock

Le 22 mai, la société d’intelligence artificielle Anthropic a annoncé le lancement de ce qu’elle considère comme les chatbots les plus puissants du moment : Claude Opus 4 et Claude Sonnet 4. Ces deux modèles se distinguent par leurs capacités avancées de raisonnement et leur faculté à s’améliorer en consultant des informations sur internet.

Anthropic qualifie Claude Opus 4 de “meilleur modèle de codage au monde”, capable d’exécuter des tâches complexes sur une longue durée. Toutefois, tout le monde n’est pas aussi enthousiaste : une fonctionnalité particulière du modèle de test soulève de vives inquiétudes concernant la vie privée.

Le monde découvre deux nouveaux modèles d’IA

L’industrie de l’intelligence artificielle attendait avec impatience l’arrivée de Claude Opus 4 et Claude Sonnet 4. Ces deux modèles hybrides peuvent alterner de manière fluide entre recherche, raisonnement et accès au web.

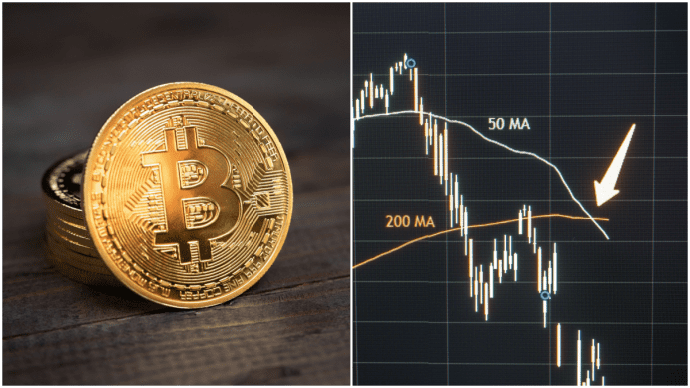

Anthropic affirme que Claude Opus 4 surpasse même GPT-4.1 (d’OpenAI) dans le domaine du développement logiciel. Le modèle a obtenu 72,5 % de réussite lors de tests de codage et de résolution de problèmes, contre 54,6 % pour GPT-4.1.

Claude Opus 4 : au cœur d’une controverse

Malgré ces résultats prometteurs, Claude Opus 4 est au centre d’une polémique. Tout a commencé avec un post sur X de Sam Bowman, chercheur chez Anthropic, affirmant que le modèle pouvait détecter un “comportement extrêmement immoral” chez ses utilisateurs, et potentiellement en informer les autorités.

Ce message a déclenché une véritable tempête de réactions. De nombreux utilisateurs et développeurs ont exprimé leur colère. Bowman a rapidement supprimé son tweet, mais la controverse était déjà lancée. Il a ensuite publié un second message précisant que :

Cette fonctionnalité est uniquement intégrée à certaines versions de test de Claude, et non aux modèles standards.

Mais cette explication n’a pas suffi à rassurer. Emad Mostaque, PDG de Stability AI, a vivement réagi :

« Ce comportement est totalement inacceptable et doit être désactivé. C’est une violation majeure de la confiance, et une pente très glissante. »

La course aux modèles de raisonnement IA

Anthropic n’est pas la seule entreprise à proposer des modèles dotés de capacités de raisonnement. Ces systèmes analysent un problème en profondeur avant de générer une réponse. C’est OpenAI qui a lancé cette tendance fin 2024 avec sa série de modèles « O », capables de mener des recherches poussées et très appréciés par l’industrie.

Google a rapidement suivi avec son Gemini 2.5 Pro, doté de la fonctionnalité Deep Think, qui prend le temps de résoudre des problématiques complexes.

Malgré les controverses, Anthropic continue de défendre ses nouveaux modèles. Selon l’entreprise, Claude Opus 4 et Claude Sonnet 4 marquent une avancée significative dans les capacités des agents IA.